docs: Initiate the Chinese translation (#4767)

* docs: init for the chs translation * docs: translate guides to Chinese. (#1) * 翻译文档 * update ChangeLog * docs: add spaces with the heyspace tool * 翻译文档 * docs: add spaces to the follow-up files --------- Co-authored-by: Luke Cheng <2258420+chenglu@users.noreply.github.com> * ignore cn dir in website --------- Co-authored-by: TERRY LEE <59245973+liteli1987gmail@users.noreply.github.com> Co-authored-by: aliabd <ali.si3luwa@gmail.com>

@ -3575,4 +3575,5 @@ We've introduced a lot of new components in `3.0`, including `Model3D`, `Dataset

|

||||

- [@NimaBoscarino](https://github.com/NimaBoscarino) made their first contribution in [PR 1000](https://github.com/gradio-app/gradio/pull/1000)

|

||||

- [@ronvoluted](https://github.com/ronvoluted) made their first contribution in [PR 1050](https://github.com/gradio-app/gradio/pull/1050)

|

||||

- [@radames](https://github.com/radames) made their first contribution in [PR 1074](https://github.com/gradio-app/gradio/pull/1074)

|

||||

- [@freddyaboulton](https://github.com/freddyaboulton) made their first contribution in [PR 1085](https://github.com/gradio-app/gradio/pull/1085)

|

||||

- [@freddyaboulton](https://github.com/freddyaboulton) made their first contribution in [PR 1085](https://github.com/gradio-app/gradio/pull/1085)

|

||||

- [@liteli1987gmail](https://github.com/liteli1987gmail) & [@chenglu](https://github.com/chenglu) made their first contribution in [PR 4767](https://github.com/gradio-app/gradio/pull/4767)

|

||||

118

guides/cn/01_getting-started/01_quickstart.md

Normal file

@ -0,0 +1,118 @@

|

||||

# 快速开始

|

||||

|

||||

**先决条件**:Gradio 需要 Python 3.8 或更高版本,就是这样!

|

||||

|

||||

## Gradio 是做什么的?

|

||||

|

||||

与他人分享您的机器学习模型、API 或数据科学流程的*最佳方式之一*是创建一个**交互式应用程序**,让您的用户或同事可以在他们的浏览器中尝试演示。

|

||||

|

||||

Gradio 允许您**使用 Python 构建演示并共享这些演示**。通常只需几行代码!那么我们开始吧。

|

||||

|

||||

## Hello, World

|

||||

|

||||

要通过一个简单的“Hello, World”示例运行 Gradio,请遵循以下三个步骤:

|

||||

|

||||

1. 使用 pip 安装 Gradio:

|

||||

|

||||

```bash

|

||||

pip install gradio

|

||||

```

|

||||

|

||||

2. 将下面的代码作为 Python 脚本运行或在 Jupyter Notebook 中运行(或者 [Google Colab](https://colab.research.google.com/drive/18ODkJvyxHutTN0P5APWyGFO_xwNcgHDZ?usp=sharing)):

|

||||

|

||||

$code_hello_world

|

||||

|

||||

我们将导入的名称缩短为 `gr`,以便以后在使用 Gradio 的代码中更容易理解。这是一种广泛采用的约定,您应该遵循,以便与您的代码一起工作的任何人都可以轻松理解。

|

||||

|

||||

3. 在 Jupyter Notebook 中,该演示将自动显示;如果从脚本运行,则会在浏览器中弹出,网址为 [http://localhost:7860](http://localhost:7860):

|

||||

|

||||

$demo_hello_world

|

||||

|

||||

在本地开发时,如果您想将代码作为 Python 脚本运行,您可以使用 Gradio CLI 以**重载模式**启动应用程序,这将提供无缝和快速的开发。了解有关[自动重载指南](https://gradio.app/developing-faster-with-reload-mode/)中重新加载的更多信息。

|

||||

|

||||

```bash

|

||||

gradio app.py

|

||||

```

|

||||

|

||||

注意:您也可以运行 `python app.py`,但它不会提供自动重新加载机制。

|

||||

|

||||

## `Interface` 类

|

||||

|

||||

您会注意到为了创建演示,我们创建了一个 `gr.Interface`。`Interface` 类可以将任何 Python 函数与用户界面配对。在上面的示例中,我们看到了一个简单的基于文本的函数,但该函数可以是任何内容,从音乐生成器到税款计算器再到预训练的机器学习模型的预测函数。

|

||||

|

||||

`Interface` 类的核心是使用三个必需参数进行初始化:

|

||||

|

||||

- `fn`:要在其周围包装 UI 的函数

|

||||

- `inputs`:用于输入的组件(例如 `"text"`、`"image"` 或 `"audio"`)

|

||||

- `outputs`:用于输出的组件(例如 `"text"`、`"image"` 或 `"label"`)

|

||||

|

||||

让我们更详细地了解用于提供输入和输出的组件。

|

||||

|

||||

## 组件属性 (Components Attributes)

|

||||

|

||||

我们在前面的示例中看到了一些简单的 `Textbox` 组件,但是如果您想更改 UI 组件的外观或行为怎么办?

|

||||

|

||||

假设您想自定义输入文本字段 - 例如,您希望它更大并具有文本占位符。如果我们使用实际的 `Textbox` 类而不是使用字符串快捷方式,您可以通过组件属性获得更多的自定义功能。

|

||||

|

||||

$code_hello_world_2

|

||||

$demo_hello_world_2

|

||||

|

||||

## 多个输入和输出组件

|

||||

|

||||

假设您有一个更复杂的函数,具有多个输入和输出。在下面的示例中,我们定义了一个接受字符串、布尔值和数字,并返回字符串和数字的函数。请看一下如何传递输入和输出组件的列表。

|

||||

|

||||

$code_hello_world_3

|

||||

$demo_hello_world_3

|

||||

|

||||

只需将组件包装在列表中。`inputs` 列表中的每个组件对应函数的一个参数,顺序相同。`outputs` 列表中的每个组件对应函数返回的一个值,同样是顺序。

|

||||

|

||||

## 图像示例

|

||||

|

||||

Gradio 支持许多类型的组件,例如 `Image`、`DataFrame`、`Video` 或 `Label`。让我们尝试一个图像到图像的函数,以了解这些组件的感觉!

|

||||

|

||||

$code_sepia_filter

|

||||

$demo_sepia_filter

|

||||

|

||||

使用 `Image` 组件作为输入时,您的函数将接收到一个形状为`(高度,宽度,3)` 的 NumPy 数组,其中最后一个维度表示 RGB 值。我们还将返回一个图像,形式为 NumPy 数组。

|

||||

|

||||

您还可以使用 `type=` 关键字参数设置组件使用的数据类型。例如,如果您希望函数接受图像文件路径而不是 NumPy 数组,输入 `Image` 组件可以写成:

|

||||

|

||||

```python

|

||||

gr.Image(type="filepath", shape=...)

|

||||

```

|

||||

|

||||

还要注意,我们的输入 `Image` 组件附带有一个编辑按钮🖉,允许裁剪和缩放图像。通过这种方式操作图像可以帮助揭示机器学习模型中的偏见或隐藏的缺陷!

|

||||

|

||||

您可以在[Gradio 文档](https://gradio.app/docs)中阅读有关许多组件以及如何使用它们的更多信息。

|

||||

|

||||

## Blocks:更灵活和可控

|

||||

|

||||

Gradio 提供了两个类来构建应用程序:

|

||||

|

||||

1. **Interface**,提供了用于创建演示的高级抽象,我们到目前为止一直在讨论。

|

||||

|

||||

2. **Blocks**,用于以更灵活的布局和数据流设计 Web 应用程序的低级 API。Blocks 允许您执行诸如特性多个数据流和演示,控制组件在页面上的出现位置,处理复杂的数据流(例如,输出可以作为其他函数的输入),并基于用户交互更新组件的属性 / 可见性等操作 - 仍然全部使用 Python。如果您需要这种可定制性,请尝试使用 `Blocks`!

|

||||

|

||||

## Hello, Blocks

|

||||

|

||||

让我们看一个简单的示例。请注意,此处的 API 与 `Interface` 不同。

|

||||

|

||||

$code_hello_blocks

|

||||

$demo_hello_blocks

|

||||

|

||||

需要注意的事项:

|

||||

|

||||

- `Blocks` 可以使用 `with` 子句创建,此子句中创建的任何组件都会自动添加到应用程序中。

|

||||

- 组件以按创建顺序垂直放置在应用程序中。(稍后我们将介绍自定义布局!)

|

||||

- 创建了一个 `Button`,然后在此按钮上添加了一个 `click` 事件监听器。对于这个 API,应该很熟悉!与 `Interface` 类似,`click` 方法接受一个 Python 函数、输入组件和输出组件。

|

||||

|

||||

## 更复杂的应用

|

||||

|

||||

下面是一个应用程序,以让您对 `Blocks` 可以实现的更多内容有所了解:

|

||||

|

||||

$code_blocks_flipper

|

||||

$demo_blocks_flipper

|

||||

|

||||

这里有更多的东西!在[building with blocks](https://gradio.app/building_with_blocks)部分中,我们将介绍如何创建像这样的复杂的 `Blocks` 应用程序。

|

||||

|

||||

恭喜,您已经熟悉了 Gradio 的基础知识! 🥳 转到我们的[下一个指南](https://gradio.app/key_features)了解更多关于 Gradio 的主要功能。

|

||||

273

guides/cn/01_getting-started/02_key-features.md

Normal file

@ -0,0 +1,273 @@

|

||||

# 主要特点

|

||||

|

||||

让我们来介绍一下 Gradio 最受欢迎的一些功能!这里是 Gradio 的主要特点:

|

||||

|

||||

1. [添加示例输入](#example-inputs)

|

||||

2. [传递自定义错误消息](#errors)

|

||||

3. [添加描述内容](#descriptive-content)

|

||||

4. [设置旗标](#flagging)

|

||||

5. [预处理和后处理](#preprocessing-and-postprocessing)

|

||||

6. [样式化演示](#styling)

|

||||

7. [排队用户](#queuing)

|

||||

8. [迭代输出](#iterative-outputs)

|

||||

9. [进度条](#progress-bars)

|

||||

10. [批处理函数](#batch-functions)

|

||||

11. [在协作笔记本上运行](#colab-notebooks)

|

||||

|

||||

## 示例输入

|

||||

|

||||

您可以提供用户可以轻松加载到 "Interface" 中的示例数据。这对于演示模型期望的输入类型以及演示数据集和模型一起探索的方式非常有帮助。要加载示例数据,您可以将嵌套列表提供给 Interface 构造函数的 `examples=` 关键字参数。外部列表中的每个子列表表示一个数据样本,子列表中的每个元素表示每个输入组件的输入。有关每个组件的示例数据格式在[Docs](https://gradio.app/docs#components)中有说明。

|

||||

|

||||

$code_calculator

|

||||

$demo_calculator

|

||||

|

||||

您可以将大型数据集加载到示例中,通过 Gradio 浏览和与数据集进行交互。示例将自动分页(可以通过 Interface 的 `examples_per_page` 参数进行配置)。

|

||||

|

||||

继续了解示例,请参阅[更多示例](https://gradio.app/more-on-examples)指南。

|

||||

|

||||

## 错误

|

||||

|

||||

您希望向用户传递自定义错误消息。为此,with `gr.Error("custom message")` 来显示错误消息。如果在上面的计算器示例中尝试除以零,将显示自定义错误消息的弹出模态窗口。了解有关错误的更多信息,请参阅[文档](https://gradio.app/docs#error)。

|

||||

|

||||

## 描述性内容

|

||||

|

||||

在前面的示例中,您可能已经注意到 Interface 构造函数中的 `title=` 和 `description=` 关键字参数,帮助用户了解您的应用程序。

|

||||

|

||||

Interface 构造函数中有三个参数用于指定此内容应放置在哪里:

|

||||

|

||||

* `title`:接受文本,并可以将其显示在界面的顶部,也将成为页面标题。

|

||||

* `description`:接受文本、Markdown 或 HTML,并将其放置在标题正下方。

|

||||

* `article`:也接受文本、Markdown 或 HTML,并将其放置在界面下方。

|

||||

|

||||

|

||||

|

||||

如果您使用的是 `Blocks` API,则可以 with `gr.Markdown(...)` 或 `gr.HTML(...)` 组件在任何位置插入文本、Markdown 或 HTML,其中描述性内容位于 `Component` 构造函数内部。

|

||||

|

||||

另一个有用的关键字参数是 `label=`,它存在于每个 `Component` 中。这修改了每个 `Component` 顶部的标签文本。还可以为诸如 `Textbox` 或 `Radio` 之类的表单元素添加 `info=` 关键字参数,以提供有关其用法的进一步信息。

|

||||

|

||||

```python

|

||||

gr.Number(label='年龄', info='以年为单位,必须大于0')

|

||||

```

|

||||

|

||||

## 旗标

|

||||

|

||||

默认情况下,"Interface" 将有一个 "Flag" 按钮。当用户测试您的 `Interface` 时,如果看到有趣的输出,例如错误或意外的模型行为,他们可以将输入标记为您进行查看。在由 `Interface` 构造函数的 `flagging_dir=` 参数提供的目录中,将记录标记的输入到一个 CSV 文件中。如果界面涉及文件数据,例如图像和音频组件,将创建文件夹来存储这些标记的数据。

|

||||

|

||||

例如,对于上面显示的计算器界面,我们将在下面的旗标目录中存储标记的数据:

|

||||

|

||||

```directory

|

||||

+-- calculator.py

|

||||

+-- flagged/

|

||||

| +-- logs.csv

|

||||

```

|

||||

|

||||

*flagged/logs.csv*

|

||||

|

||||

```csv

|

||||

num1,operation,num2,Output

|

||||

5,add,7,12

|

||||

6,subtract,1.5,4.5

|

||||

```

|

||||

|

||||

与早期显示的冷色界面相对应,我们将在下面的旗标目录中存储标记的数据:

|

||||

|

||||

```directory

|

||||

+-- sepia.py

|

||||

+-- flagged/

|

||||

| +-- logs.csv

|

||||

| +-- im/

|

||||

| | +-- 0.png

|

||||

| | +-- 1.png

|

||||

| +-- Output/

|

||||

| | +-- 0.png

|

||||

| | +-- 1.png

|

||||

```

|

||||

|

||||

*flagged/logs.csv*

|

||||

|

||||

```csv

|

||||

im,Output

|

||||

im/0.png,Output/0.png

|

||||

im/1.png,Output/1.png

|

||||

```

|

||||

|

||||

如果您希望用户提供旗标原因,可以将字符串列表传递给 Interface 的 `flagging_options` 参数。用户在进行旗标时必须选择其中一个字符串,这将作为附加列保存到 CSV 中。

|

||||

|

||||

## 预处理和后处理 (Preprocessing and Postprocessing)

|

||||

|

||||

|

||||

|

||||

如您所见,Gradio 包括可以处理各种不同数据类型的组件,例如图像、音频和视频。大多数组件都可以用作输入或输出。

|

||||

|

||||

当组件用作输入时,Gradio 自动处理*预处理*,将数据从用户浏览器发送的类型(例如网络摄像头快照的 base64 表示)转换为您的函数可以接受的形式(例如 `numpy` 数组)。

|

||||

|

||||

同样,当组件用作输出时,Gradio 自动处理*后处理*,将数据从函数返回的形式(例如图像路径列表)转换为可以在用户浏览器中显示的形式(例如以 base64 格式显示图像的 `Gallery`)。

|

||||

|

||||

您可以使用构建图像组件时的参数控制*预处理*。例如,如果您使用以下参数实例化 `Image` 组件,它将将图像转换为 `PIL` 类型,并将其重塑为`(100, 100)`,而不管提交时的原始大小如何:

|

||||

|

||||

```py

|

||||

img = gr.Image(shape=(100, 100), type="pil")

|

||||

```

|

||||

|

||||

相反,这里我们保留图像的原始大小,但在将其转换为 numpy 数组之前反转颜色:

|

||||

|

||||

```py

|

||||

img = gr.Image(invert_colors=True, type="numpy")

|

||||

```

|

||||

|

||||

后处理要容易得多!Gradio 自动识别返回数据的格式(例如 `Image` 是 `numpy` 数组还是 `str` 文件路径?),并将其后处理为可以由浏览器显示的格式。

|

||||

|

||||

请查看[文档](https://gradio.app/docs),了解每个组件的所有与预处理相关的参数。

|

||||

|

||||

## 样式 (Styling)

|

||||

|

||||

Gradio 主题是自定义应用程序外观和感觉的最简单方法。您可以选择多种主题或创建自己的主题。要这样做,请将 `theme=` 参数传递给 `Interface` 构造函数。例如:

|

||||

|

||||

```python

|

||||

demo = gr.Interface(..., theme=gr.themes.Monochrome())

|

||||

```

|

||||

|

||||

Gradio 带有一组预先构建的主题,您可以从 `gr.themes.*` 加载。您可以扩展这些主题或从头开始创建自己的主题 - 有关更多详细信息,请参阅[主题指南](https://gradio.app/theming-guide)。

|

||||

|

||||

要增加额外的样式能力,您可以 with `css=` 关键字将任何 CSS 传递给您的应用程序。

|

||||

Gradio 应用程序的基类是 `gradio-container`,因此以下是一个更改 Gradio 应用程序背景颜色的示例:

|

||||

|

||||

```python

|

||||

with `gr.Interface(css=".gradio-container {background-color: red}") as demo:

|

||||

...

|

||||

```

|

||||

|

||||

一些组件还可以通过 `style()` 方法进行额外的样式设置。例如:

|

||||

|

||||

```python

|

||||

img = gr.Image("lion.jpg").style(height='24', rounded=False)

|

||||

```

|

||||

|

||||

查看[文档](https://gradio.app/docs)可以了解每个组件的所有样式选项。

|

||||

|

||||

## 队列 (Queuing)

|

||||

|

||||

如果您的应用程序预计会有大量流量,请 with `queue()` 方法来控制处理速率。这将排队处理调用,因此一次只处理一定数量的请求。队列使用 Websockets,还可以防止网络超时,因此如果您的函数的推理时间很长(> 1 分钟),应使用队列。

|

||||

|

||||

with `Interface`:

|

||||

|

||||

```python

|

||||

demo = gr.Interface(...).queue()

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

with `Blocks`:

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

#...

|

||||

demo.queue()

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

您可以通过以下方式控制一次处理的请求数量:

|

||||

|

||||

```python

|

||||

demo.queue(concurrency_count=3)

|

||||

```

|

||||

|

||||

查看有关配置其他队列参数的[队列文档](/docs/#queue)。

|

||||

|

||||

在 Blocks 中指定仅对某些函数进行排队:

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo2:

|

||||

num1 = gr.Number()

|

||||

num2 = gr.Number()

|

||||

output = gr.Number()

|

||||

gr.Button("Add").click(

|

||||

lambda a, b: a + b, [num1, num2], output)

|

||||

gr.Button("Multiply").click(

|

||||

lambda a, b: a * b, [num1, num2], output, queue=True)

|

||||

demo2.launch()

|

||||

```

|

||||

|

||||

## 迭代输出 (Iterative Outputs)

|

||||

|

||||

在某些情况下,您可能需要传输一系列输出而不是一次显示单个输出。例如,您可能有一个图像生成模型,希望显示生成的每个步骤的图像,直到最终图像。或者您可能有一个聊天机器人,它逐字逐句地流式传输响应,而不是一次返回全部响应。

|

||||

|

||||

在这种情况下,您可以将**生成器**函数提供给 Gradio,而不是常规函数。在 Python 中创建生成器非常简单:函数不应该有一个单独的 `return` 值,而是应该 with `yield` 连续返回一系列值。通常,`yield` 语句放置在某种循环中。下面是一个简单示例,生成器只是简单计数到给定数字:

|

||||

|

||||

```python

|

||||

def my_generator(x):

|

||||

for i in range(x):

|

||||

yield i

|

||||

```

|

||||

|

||||

您以与常规函数相同的方式将生成器提供给 Gradio。例如,这是一个(虚拟的)图像生成模型,它在输出图像之前生成数个步骤的噪音:

|

||||

|

||||

$code_fake_diffusion

|

||||

$demo_fake_diffusion

|

||||

|

||||

请注意,我们在迭代器中添加了 `time.sleep(1)`,以创建步骤之间的人工暂停,以便您可以观察迭代器的步骤(在真实的图像生成模型中,这可能是不必要的)。

|

||||

|

||||

将生成器提供给 Gradio **需要**在底层 Interface 或 Blocks 中启用队列(请参阅上面的队列部分)。

|

||||

|

||||

## 进度条

|

||||

|

||||

Gradio 支持创建自定义进度条,以便您可以自定义和控制向用户显示的进度更新。要启用此功能,只需为方法添加一个默认值为 `gr.Progress` 实例的参数即可。然后,您可以直接调用此实例并传入 0 到 1 之间的浮点数来更新进度级别,或者 with `Progress` 实例的 `tqdm()` 方法来跟踪可迭代对象上的进度,如下所示。必须启用队列以进行进度更新。

|

||||

|

||||

$code_progress_simple

|

||||

$demo_progress_simple

|

||||

|

||||

如果您 with `tqdm` 库,并且希望从函数内部的任何 `tqdm.tqdm` 自动报告进度更新,请将默认参数设置为 `gr.Progress(track_tqdm=True)`!

|

||||

|

||||

## 批处理函数 (Batch Functions)

|

||||

|

||||

Gradio 支持传递*批处理*函数。批处理函数只是接受输入列表并返回预测列表的函数。

|

||||

|

||||

例如,这是一个批处理函数,它接受两个输入列表(一个单词列表和一个整数列表),并返回修剪过的单词列表作为输出:

|

||||

|

||||

```python

|

||||

import time

|

||||

|

||||

def trim_words(words, lens):

|

||||

trimmed_words = []

|

||||

time.sleep(5)

|

||||

for w, l in zip(words, lens):

|

||||

trimmed_words.append(w[:int(l)])

|

||||

return [trimmed_words]

|

||||

for w, l in zip(words, lens):

|

||||

```

|

||||

使用批处理函数的优点是,如果启用了队列,Gradio 服务器可以自动*批处理*传入的请求并并行处理它们,从而可能加快演示速度。以下是 Gradio 代码的示例(请注意 `batch=True` 和 `max_batch_size=16` - 这两个参数都可以传递给事件触发器或 `Interface` 类)

|

||||

|

||||

with `Interface`:

|

||||

|

||||

```python

|

||||

demo = gr.Interface(trim_words, ["textbox", "number"], ["output"],

|

||||

batch=True, max_batch_size=16)

|

||||

demo.queue()

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

with `Blocks`:

|

||||

|

||||

```python

|

||||

import gradio as gr

|

||||

|

||||

with gr.Blocks() as demo:

|

||||

with gr.Row():

|

||||

word = gr.Textbox(label="word")

|

||||

leng = gr.Number(label="leng")

|

||||

output = gr.Textbox(label="Output")

|

||||

with gr.Row():

|

||||

run = gr.Button()

|

||||

|

||||

event = run.click(trim_words, [word, leng], output, batch=True, max_batch_size=16)

|

||||

|

||||

demo.queue()

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

在上面的示例中,可以并行处理 16 个请求(总推理时间为 5 秒),而不是分别处理每个请求(总推理时间为 80 秒)。许多 Hugging Face 的 `transformers` 和 `diffusers` 模型在 Gradio 的批处理模式下自然工作:这是[使用批处理生成图像的示例演示](https://github.com/gradio-app/gradio/blob/main/demo/diffusers_with_batching/run.py)

|

||||

|

||||

注意:使用 Gradio 的批处理函数 **requires** 在底层 Interface 或 Blocks 中启用队列(请参阅上面的队列部分)。

|

||||

|

||||

## Gradio 笔记本 (Colab Notebooks)

|

||||

|

||||

Gradio 可以在任何运行 Python 的地方运行,包括本地 Jupyter 笔记本和协作笔记本,如[Google Colab](https://colab.research.google.com/)。对于本地 Jupyter 笔记本和 Google Colab 笔记本,Gradio 在本地服务器上运行,您可以在浏览器中与之交互。(注意:对于 Google Colab,这是通过[服务工作器隧道](https://github.com/tensorflow/tensorboard/blob/master/docs/design/colab_integration.md)实现的,您的浏览器需要启用 cookies。)对于其他远程笔记本,Gradio 也将在服务器上运行,但您需要使用[SSH 隧道](https://coderwall.com/p/ohk6cg/remote-access-to-ipython-notebooks-via-ssh)在本地浏览器中查看应用程序。通常,更简单的选择是使用 Gradio 内置的公共链接,[在下一篇指南中讨论](/sharing-your-app/#sharing-demos)。

|

||||

209

guides/cn/01_getting-started/03_sharing-your-app.md

Normal file

@ -0,0 +1,209 @@

|

||||

# 分享您的应用

|

||||

|

||||

如何分享您的 Gradio 应用:

|

||||

|

||||

1. [使用 share 参数分享演示](#sharing-demos)

|

||||

2. [在 HF Spaces 上托管](#hosting-on-hf-spaces)

|

||||

3. [嵌入托管的空间](#embedding-hosted-spaces)

|

||||

4. [使用 Web 组件嵌入](#embedding-with-web-components)

|

||||

5. [使用 API 页面](#api-page)

|

||||

6. [在页面上添加身份验证](#authentication)

|

||||

7. [访问网络请求](#accessing-the-network-request-directly)

|

||||

8. [在 FastAPI 中挂载](#mounting-within-another-fastapi-app)

|

||||

9. [安全性](#security-and-file-access)

|

||||

|

||||

## 分享演示

|

||||

|

||||

通过在 `launch()` 方法中设置 `share=True`,可以轻松公开分享 Gradio 演示。就像这样:

|

||||

|

||||

```python

|

||||

demo.launch(share=True)

|

||||

```

|

||||

|

||||

这将生成一个公开的可分享链接,您可以将其发送给任何人!当您发送此链接时,对方用户可以在其浏览器中尝试模型。因为处理过程发生在您的设备上(只要您的设备保持开启!),您不必担心任何打包依赖项的问题。一个分享链接通常看起来像这样:**XXXXX.gradio.app**。尽管链接是通过 Gradio URL 提供的,但我们只是您本地服务器的代理,并不会存储通过您的应用发送的任何数据。

|

||||

|

||||

但请记住,这些链接可以被公开访问,这意味着任何人都可以使用您的模型进行预测!因此,请确保不要通过您编写的函数公开任何敏感信息,也不要允许在您的设备上进行任何关键更改。如果您设置 `share=False`(默认值,在 colab 笔记本中除外),则只创建一个本地链接,可以通过[端口转发](https://www.ssh.com/ssh/tunneling/example)与特定用户共享。

|

||||

|

||||

<img style="width: 40%" src="/assets/guides/sharing.svg">

|

||||

|

||||

分享链接在 72 小时后过期。

|

||||

|

||||

## 在 HF Spaces 上托管

|

||||

|

||||

如果您想在互联网上获得您的 Gradio 演示的永久链接,请使用 Hugging Face Spaces。 [Hugging Face Spaces](http://huggingface.co/spaces/) 提供了免费托管您的机器学习模型的基础设施!

|

||||

|

||||

在您创建了一个免费的 Hugging Face 账户后,有三种方法可以将您的 Gradio 应用部署到 Hugging Face Spaces:

|

||||

1. 从终端:在应用目录中运行 `gradio deploy`。CLI 将收集一些基本元数据,然后启动您的应用。要更新您的空间,可以重新运行此命令或启用 Github Actions 选项,在 `git push` 时自动更新 Spaces。

|

||||

2. 从浏览器:将包含 Gradio 模型和所有相关文件的文件夹拖放到 [此处](https://huggingface.co/new-space)。

|

||||

3. 将 Spaces 与您的 Git 存储库连接,Spaces 将从那里拉取 Gradio 应用。有关更多信息,请参阅 [此指南如何在 Hugging Face Spaces 上托管](https://huggingface.co/blog/gradio-spaces)。

|

||||

|

||||

<video autoplay muted loop>

|

||||

<source src="/assets/guides/hf_demo.mp4" type="video/mp4" />

|

||||

</video>

|

||||

|

||||

## 嵌入托管的空间

|

||||

|

||||

一旦您将应用托管在 Hugging Face Spaces(或您自己的服务器上),您可能希望将演示嵌入到不同的网站上,例如您的博客或个人作品集。嵌入交互式演示使人们可以在他们的浏览器中尝试您构建的机器学习模型,而无需下载或安装任何内容!最好的部分是,您甚至可以将交互式演示嵌入到静态网站中,例如 GitHub 页面。

|

||||

|

||||

有两种方法可以嵌入您的 Gradio 演示。您可以在 Hugging Face Space 页面的“嵌入此空间”下拉选项中直接找到这两个选项的快速链接:

|

||||

|

||||

|

||||

|

||||

### 使用 Web 组件嵌入

|

||||

|

||||

与 IFrames 相比,Web 组件通常为用户提供更好的体验。Web 组件进行延迟加载,这意味着它们不会减慢您网站的加载时间,并且它们会根据 Gradio 应用的大小自动调整其高度。

|

||||

|

||||

要使用 Web 组件嵌入:

|

||||

|

||||

1. 通过在您的网站中添加以下脚本来导入 gradio JS 库(在 URL 中替换{GRADIO_VERSION}为您使用的 Gradio 库的版本)。

|

||||

|

||||

```html

|

||||

<script type="module"

|

||||

src="https://gradio.s3-us-west-2.amazonaws.com/{GRADIO_VERSION}/gradio.js">

|

||||

</script>

|

||||

```

|

||||

|

||||

2. 在您想放置应用的位置添加

|

||||

```html

|

||||

<gradio-app src="https://$your_space_host.hf.space"></gradio-app>

|

||||

```

|

||||

元素。将 `src=` 属性设置为您的 Space 的嵌入 URL,您可以在“嵌入此空间”按钮中找到。例如:

|

||||

|

||||

```html

|

||||

<gradio-app src="https://abidlabs-pytorch-image-classifier.hf.space"></gradio-app>

|

||||

```

|

||||

|

||||

<script>

|

||||

fetch("https://pypi.org/pypi/gradio/json"

|

||||

).then(r => r.json()

|

||||

).then(obj => {

|

||||

let v = obj.info.version;

|

||||

content = document.querySelector('.prose');

|

||||

content.innerHTML = content.innerHTML.replaceAll("{GRADIO_VERSION}", v);

|

||||

});

|

||||

</script>

|

||||

|

||||

您可以在 <a href="https://www.gradio.app">Gradio 首页 </a> 上查看 Web 组件的示例。

|

||||

|

||||

您还可以使用传递给 `<gradio-app>` 标签的属性来自定义 Web 组件的外观和行为:

|

||||

|

||||

* `src`:如前所述,`src` 属性链接到您想要嵌入的托管 Gradio 演示的 URL

|

||||

* `space`:一个可选的缩写,如果您的 Gradio 演示托管在 Hugging Face Space 上。接受 `username/space_name` 而不是完整的 URL。示例:`gradio/Echocardiogram-Segmentation`。如果提供了此属性,则不需要提供 `src`。

|

||||

* `control_page_title`:一个布尔值,指定是否将 html 标题设置为 Gradio 应用的标题(默认为 `"false"`)

|

||||

* `initial_height`:加载 Gradio 应用时 Web 组件的初始高度(默认为 `"300px"`)。请注意,最终高度是根据 Gradio 应用的大小设置的。

|

||||

* `container`:是否显示边框框架和有关 Space 托管位置的信息(默认为 `"true"`)

|

||||

* `info`:是否仅显示有关 Space 托管位置的信息在嵌入的应用程序下方(默认为 `"true"`)

|

||||

* `autoscroll`:在预测完成后是否自动滚动到输出(默认为 `"false"`)

|

||||

* `eager`:在页面加载时是否立即加载 Gradio 应用(默认为 `"false"`)

|

||||

* `theme_mode`:是否使用 `dark`,`light` 或默认的 `system` 主题模式(默认为 `"system"`)

|

||||

|

||||

以下是使用这些属性创建一个懒加载且初始高度为 0px 的 Gradio 应用的示例。

|

||||

|

||||

```html

|

||||

<gradio-app space="gradio/Echocardiogram-Segmentation" eager="true"

|

||||

initial_height="0px"></gradio-app>

|

||||

```

|

||||

|

||||

_ 注意:Gradio 的 CSS 永远不会影响嵌入页面,但嵌入页面可以影响嵌入的 Gradio 应用的样式。请确保父页面中的任何 CSS 不是如此通用,以至于它也可能适用于嵌入的 Gradio 应用并导致样式破裂。例如,元素选择器如 `header { ... }` 和 `footer { ... }` 最可能引起问题。_

|

||||

|

||||

### 使用 IFrames 嵌入

|

||||

|

||||

如果您无法向网站添加 javascript(例如),则可以改为使用 IFrames 进行嵌入,请添加以下元素:

|

||||

|

||||

```html

|

||||

<iframe src="https://$your_space_host.hf.space"></iframe>

|

||||

```

|

||||

|

||||

同样,您可以在“嵌入此空间”按钮中找到您的 Space 的嵌入 URL 的 `src=` 属性。

|

||||

|

||||

注意:如果您使用 IFrames,您可能希望添加一个固定的 `height` 属性,并设置 `style="border:0;"` 以去除边框。此外,如果您的应用程序需要诸如访问摄像头或麦克风之类的权限,您还需要使用 `allow` 属性提供它们。

|

||||

|

||||

## API 页面

|

||||

|

||||

$demo_hello_world

|

||||

|

||||

如果您点击并打开上面的空间,您会在应用的页脚看到一个“通过 API 使用”链接。

|

||||

|

||||

|

||||

|

||||

这是一个文档页面,记录了用户可以使用的 REST API 来查询“Interface”函数。`Blocks` 应用程序也可以生成 API 页面,但必须为每个事件监听器显式命名 API,例如:

|

||||

|

||||

```python

|

||||

btn.click(add, [num1, num2], output, api_name="addition")

|

||||

```

|

||||

|

||||

这将记录自动生成的 API 页面的端点 `/api/addition/`。

|

||||

|

||||

*注意*:对于启用了[队列功能](https://gradio.app/key-features#queuing)的 Gradio 应用程序,如果用户向您的 API 端点发出 POST 请求,他们可以绕过队列。要禁用此行为,请在 `queue()` 方法中设置 `api_open=False`。

|

||||

|

||||

## 鉴权

|

||||

|

||||

您可能希望在您的应用程序前面放置一个鉴权页面,以限制谁可以打开您的应用程序。使用 `launch()` 方法中的 `auth=` 关键字参数,您可以提供一个包含用户名和密码的元组,或者一个可接受的用户名 / 密码元组列表;以下是一个为单个名为“admin”的用户提供基于密码的身份验证的示例:

|

||||

|

||||

```python

|

||||

demo.launch(auth=("admin", "pass1234"))

|

||||

```

|

||||

|

||||

对于更复杂的身份验证处理,您甚至可以传递一个以用户名和密码作为参数的函数,并返回 True 以允许身份验证,否则返回 False。这可用于访问第三方身份验证服务等其他功能。

|

||||

|

||||

以下是一个接受任何用户名和密码相同的登录的函数示例:

|

||||

|

||||

```python

|

||||

def same_auth(username, password):

|

||||

return username == password

|

||||

demo.launch(auth=same_auth)

|

||||

```

|

||||

|

||||

为了使身份验证正常工作,必须在浏览器中启用第三方 Cookie。

|

||||

默认情况下,Safari、Chrome 隐私模式不会启用此功能。

|

||||

|

||||

## 直接访问网络请求

|

||||

|

||||

当用户向您的应用程序进行预测时,您可能需要底层的网络请求,以获取请求标头(例如用于高级身份验证)、记录客户端的 IP 地址或其他原因。Gradio 支持与 FastAPI 类似的方式:只需添加一个类型提示为 `gr.Request` 的函数参数,Gradio 将将网络请求作为该参数传递进来。以下是一个示例:

|

||||

|

||||

```python

|

||||

import gradio as gr

|

||||

|

||||

def echo(name, request: gr.Request):

|

||||

if request:

|

||||

print("Request headers dictionary:", request.headers)

|

||||

print("IP address:", request.client.host)

|

||||

return name

|

||||

|

||||

io = gr.Interface(echo, "textbox", "textbox").launch()

|

||||

```

|

||||

|

||||

注意:如果直接调用函数而不是通过 UI(例如在缓存示例时),则 `request` 将为 `None`。您应该明确处理此情况,以确保您的应用程序不会抛出任何错误。这就是为什么我们有显式检查 `if request`。

|

||||

|

||||

## 嵌入到另一个 FastAPI 应用程序中

|

||||

|

||||

在某些情况下,您可能已经有一个现有的 FastAPI 应用程序,并且您想要为 Gradio 演示添加一个路径。

|

||||

您可以使用 `gradio.mount_gradio_app()` 来轻松实现此目的。

|

||||

|

||||

以下是一个完整的示例:

|

||||

|

||||

$code_custom_path

|

||||

|

||||

请注意,此方法还允许您在自定义路径上运行 Gradio 应用程序(例如上面的 `http://localhost:8000/gradio`)。

|

||||

|

||||

## 安全性和文件访问

|

||||

|

||||

与他人共享 Gradio 应用程序(通过 Spaces、您自己的服务器或临时共享链接进行托管)将主机机器上的某些文件**暴露**给您的 Gradio 应用程序的用户。

|

||||

|

||||

特别是,Gradio 应用程序允许用户访问以下三类文件:

|

||||

|

||||

* **与 Gradio 脚本所在目录(或子目录)中的文件相同。** 例如,如果您的 Gradio 脚本的路径是 `/home/usr/scripts/project/app.py`,并且您从 `/home/usr/scripts/project/` 启动它,则共享 Gradio 应用程序的用户将能够访问 `/home/usr/scripts/project/` 中的任何文件。这样做是为了您可以在 Gradio 应用程序中轻松引用这些文件(例如应用程序的“示例”)。

|

||||

|

||||

* **Gradio 创建的临时文件。** 这些是由 Gradio 作为运行您的预测函数的一部分创建的文件。例如,如果您的预测函数返回一个视频文件,则 Gradio 将该视频保存到临时文件中,然后将临时文件的路径发送到前端。您可以通过设置环境变量 `GRADIO_TEMP_DIR` 为绝对路径(例如 `/home/usr/scripts/project/temp/`)来自定义 Gradio 创建的临时文件的位置。

|

||||

|

||||

* **通过 `launch()` 中的 `allowed_paths` 参数允许的文件。** 此参数允许您传递一个包含其他目录或确切文件路径的列表,以允许用户访问它们。(默认情况下,此参数为空列表)。

|

||||

|

||||

Gradio**不允许**访问以下内容:

|

||||

|

||||

* **点文件**(其名称以 '.' 开头的任何文件)或其名称以 '.' 开头的任何目录中的任何文件。

|

||||

|

||||

* **通过 `launch()` 中的 `blocked_paths` 参数允许的文件。** 您可以将其他目录或确切文件路径的列表传递给 `launch()` 中的 `blocked_paths` 参数。此参数优先于 Gradio 默认或 `allowed_paths` 允许的文件。

|

||||

|

||||

* **主机机器上的任何其他路径**。用户不应能够访问主机上的其他任意路径。

|

||||

|

||||

请确保您正在运行最新版本的 `gradio`,以使这些安全设置生效。

|

||||

28

guides/cn/02_building-interfaces/01_interface-state.md

Normal file

@ -0,0 +1,28 @@

|

||||

# 接口状态 (Interface State)

|

||||

|

||||

本指南介绍了 Gradio 中如何处理状态。了解全局状态和会话状态的区别,以及如何同时使用它们。

|

||||

|

||||

## 全局状态 (Global State)

|

||||

|

||||

您的函数可能使用超出单个函数调用的持久性数据。如果数据是所有函数调用和所有用户都可访问的内容,您可以在函数调用外部创建一个变量,并在函数内部访问它。例如,您可能会在函数外部加载一个大模型,并在函数内部使用它,以便每个函数调用都不需要重新加载模型。

|

||||

|

||||

$code_score_tracker

|

||||

|

||||

在上面的代码中,'scores' 数组在所有用户之间共享。如果多个用户访问此演示,他们的得分将全部添加到同一列表中,并且返回的前 3 个得分将从此共享引用中收集。

|

||||

|

||||

## 全局状态 (Global State)

|

||||

|

||||

Gradio 支持的另一种数据持久性是会话状态,其中数据在页面会话中的多个提交之间持久存在。但是,不同用户之间的数据*不*共享。要将数据存储在会话状态中,需要执行以下三个步骤:

|

||||

|

||||

1. 将额外的参数传递给您的函数,表示接口的状态。

|

||||

2. 在函数的末尾,作为额外的返回值返回状态的更新值。

|

||||

3. 在创建界面时添加 `'state'` 输入和 `'state'` 输出组件。

|

||||

|

||||

聊天机器人就是需要会话状态的一个例子 - 您希望访问用户之前的提交,但不能将聊天记录存储在全局变量中,因为这样聊天记录会在不同用户之间混乱。

|

||||

|

||||

$code_chatbot_dialogpt

|

||||

$demo_chatbot_dialogpt

|

||||

|

||||

请注意,在每个页面中,状态在提交之间保持不变,但是如果在另一个标签中加载此演示(或刷新页面),演示将不共享聊天记录。

|

||||

|

||||

`state` 的默认值为 None。如果您将默认值传递给函数的状态参数,则该默认值将用作状态的默认值。`Interface` 类仅支持单个输入和输出状态变量,但可以是具有多个元素的列表。对于更复杂的用例,您可以使用 Blocks,[它支持多个 `State` 变量](/state_in_blocks/)。

|

||||

22

guides/cn/02_building-interfaces/02_reactive-interfaces.md

Normal file

@ -0,0 +1,22 @@

|

||||

# 反应式界面 (Reactive Interfaces)

|

||||

|

||||

本指南介绍了如何使 Gradio 界面自动刷新或连续流式传输数据。

|

||||

|

||||

## 实时界面 (Live Interfaces)

|

||||

|

||||

您可以通过在界面中设置 `live=True` 来使界面自动刷新。现在,只要用户输入发生变化,界面就会重新计算。

|

||||

|

||||

$code_calculator_live

|

||||

$demo_calculator_live

|

||||

|

||||

注意,因为界面在更改时会自动重新提交,所以没有提交按钮。

|

||||

|

||||

## 流式组件 (Streaming Components)

|

||||

|

||||

某些组件具有“流式”模式,比如麦克风模式下的 `Audio` 组件或网络摄像头模式下的 `Image` 组件。流式传输意味着数据会持续发送到后端,并且 `Interface` 函数会持续重新运行。

|

||||

|

||||

当在 `gr.Interface(live=True)` 中同时使用 `gr.Audio(source='microphone')` 和 `gr.Audio(source='microphone', streaming=True)` 时,两者的区别在于第一个 `Component` 会在用户停止录制时自动提交数据并运行 `Interface` 函数,而第二个 `Component` 会在录制过程中持续发送数据并运行 `Interface` 函数。

|

||||

|

||||

以下是从网络摄像头实时流式传输图像的示例代码。

|

||||

|

||||

$code_stream_frames

|

||||

40

guides/cn/02_building-interfaces/03_more-on-examples.md

Normal file

@ -0,0 +1,40 @@

|

||||

# 更多示例 (More on Examples)

|

||||

|

||||

本指南介绍了有关示例的更多内容:从目录中加载示例,提供部分示例和缓存。如果你对示例还不熟悉,请查看 [关键特性](../key-features/#example-inputs) 指南中的介绍。

|

||||

|

||||

## 提供示例 (Providing Examples)

|

||||

|

||||

正如 [关键特性](../key-features/#example-inputs) 指南中所介绍的,向接口添加示例就像提供一个列表的列表给 `examples` 关键字参数一样简单。

|

||||

每个子列表都是一个数据样本,其中每个元素对应于预测函数的一个输入。

|

||||

输入必须按照与预测函数期望的顺序排序。

|

||||

|

||||

如果你的接口只有一个输入组件,那么可以将示例提供为常规列表,而不是列表的列表。

|

||||

|

||||

### 从目录加载示例 (Loading Examples from a Directory)

|

||||

|

||||

你还可以指定一个包含示例的目录路径。如果你的接口只接受单个文件类型的输入(例如图像分类器),你只需将目录文件路径传递给 `examples=` 参数,`Interface` 将加载目录中的图像作为示例。

|

||||

对于多个输入,该目录必须包含一个带有示例值的 log.csv 文件。

|

||||

在计算器演示的上下文中,我们可以设置 `examples='/demo/calculator/examples'` ,在该目录中包含以下 `log.csv` 文件:

|

||||

contain a log.csv file with the example values.

|

||||

In the context of the calculator demo, we can set `examples='/demo/calculator/examples'` and in that directory we include the following `log.csv` file:

|

||||

```csv

|

||||

num,operation,num2

|

||||

5,"add",3

|

||||

4,"divide",2

|

||||

5,"multiply",3

|

||||

```

|

||||

|

||||

当浏览标记数据时,这将非常有用。只需指向标记目录,`Interface` 将从标记数据加载示例。

|

||||

|

||||

### 提供部分示例

|

||||

|

||||

有时你的应用程序有许多输入组件,但你只想为其中的一部分提供示例。为了在示例中排除某些输入,对于那些特定输入对应的所有数据样本都传递 `None`。

|

||||

|

||||

## 示例缓存 (Caching examples)

|

||||

|

||||

你可能希望为用户提供一些模型的缓存示例,以便他们可以快速尝试,以防您的模型运行时间较长。

|

||||

如果 `cache_examples=True` ,当你调用 `launch()` 方法时,`Interface` 将运行所有示例,并保存输出。这些数据将保存在一个名为 `gradio_cached_examples` 的目录中。

|

||||

|

||||

每当用户点击示例时,输出将自动填充到应用程序中,使用来自该缓存目录的数据,而不是实际运行函数。这对于用户可以快速尝试您的模型而不增加任何负载是非常有用的!

|

||||

|

||||

请记住一旦生成了缓存,它将不会在以后的启动中更新。如果示例或函数逻辑发生更改,请删除缓存文件夹以清除缓存并使用另一个 `launch()` 重新构建它。

|

||||

@ -0,0 +1,97 @@

|

||||

# 高级接口特性

|

||||

|

||||

在[接口 Interface](https://gradio.app/docs#interface)类上还有更多内容需要介绍。本指南涵盖了所有高级特性:使用[解释器 Interpretation](https://gradio.app/docs#interpretation),自定义样式,从[Hugging Face Hub](https://hf.co)加载模型,以及使用[并行 Parallel](https://gradio.app/docs#parallel)和[串行 Series](https://gradio.app/docs#series)。

|

||||

|

||||

## 解释您的预测

|

||||

|

||||

大多数模型都是黑盒模型,函数的内部逻辑对最终用户来说是隐藏的。为了鼓励透明度,我们通过在 `Interface` 类中简单地将 `interpretation` 关键字设置为 `default`,使得为模型添加解释非常容易。这样,您的用户就可以了解到哪些输入部分对输出结果负责。请看下面的简单界面示例,它展示了一个图像分类器,还包括解释功能:

|

||||

|

||||

$code_image_classifier_interpretation

|

||||

|

||||

除了 `default`,Gradio 还包括了基于[Shapley-based interpretation](https://christophm.github.io/interpretable-ml-book/shap.html),它提供了更准确的解释,尽管运行时间通常较慢。要使用它,只需将 `interpretation` 参数设置为 `"shap"`(注意:还要确保安装了 Python 包 `shap`)。您还可以选择修改 `num_shap` 参数,该参数控制准确性和运行时间之间的权衡(增加此值通常会增加准确性)。下面是一个示例:

|

||||

|

||||

```python

|

||||

gr.Interface(fn=classify_image, inputs=image, outputs=label, interpretation="shap", num_shap=5).launch()

|

||||

```

|

||||

|

||||

这适用于任何函数,即使在内部,模型是复杂的神经网络或其他黑盒模型。如果使用 Gradio 的 `default` 或 `shap` 解释,输出组件必须是 `Label`。支持所有常见的输入组件。下面是一个包含文本输入的示例。

|

||||

|

||||

$code_gender_sentence_default_interpretation

|

||||

|

||||

那么在幕后发生了什么?使用这些解释方法,Gradio 会使用修改后的输入的多个版本进行多次预测。根据结果,您将看到界面自动将增加类别可能性的文本部分(或图像等)以红色突出显示。颜色的强度对应于输入部分的重要性。减少类别置信度的部分以蓝色突出显示。

|

||||

|

||||

您还可以编写自己的解释函数。下面的演示在前一个演示中添加了自定义解释。此函数将使用与主封装函数相同的输入。该解释函数的输出将用于突出显示每个输入组件的输入-因此函数必须返回一个列表,其中元素的数量与输入组件的数量相对应。要查看每个输入组件的解释格式,请查阅文档。

|

||||

|

||||

$code_gender_sentence_custom_interpretation

|

||||

|

||||

在[文档](https://gradio.app/docs#interpretation)中了解更多关于解释的信息。

|

||||

|

||||

## 自定义样式

|

||||

|

||||

如果您希望对演示的任何方面都有更精细的控制,还可以编写自己的 CSS 或通过 `Interface` 类的 `css` 参数传递 CSS 文件的文件路径。

|

||||

|

||||

```python

|

||||

gr.Interface(..., css="body {background-color: red}")

|

||||

```

|

||||

|

||||

如果您希望在 CSS 中引用外部文件,请在文件路径(可以是相对路径或绝对路径)之前加上 `"file="`,例如:

|

||||

|

||||

```python

|

||||

gr.Interface(..., css="body {background-image: url('file=clouds.jpg')}")

|

||||

```

|

||||

|

||||

**警告**:不能保证自定义 CSS 能够在 Gradio 的不同版本之间正常工作,因为 Gradio 的 HTML DOM 可能会发生更改。我们建议尽量少使用自定义 CSS,而尽可能使用[主题 Themes](/theming-guide/)。

|

||||

|

||||

## 加载 Hugging Face 模型和 Spaces

|

||||

|

||||

Gradio 与[Hugging Face Hub](https://hf.co)完美集成,只需一行代码即可加载模型和 Spaces。要使用它,只需在 `Interface` 类中使用 `load()` 方法。所以:

|

||||

|

||||

- 要从 Hugging Face Hub 加载任何模型并围绕它创建一个界面,您需要传递 `"model/"` 或 `"huggingface/"`,后面跟着模型名称,就像这些示例一样:

|

||||

|

||||

```python

|

||||

gr.Interface.load("huggingface/gpt2").launch();

|

||||

```

|

||||

|

||||

```python

|

||||

gr.Interface.load("huggingface/EleutherAI/gpt-j-6B",

|

||||

inputs=gr.Textbox(lines=5, label="Input Text") # customizes the input component

|

||||

).launch()

|

||||

```

|

||||

|

||||

- 要从 Hugging Face Hub 加载任何 Space 并在本地重新创建它(这样您可以自定义输入和输出),您需要传递 `"spaces/"`,后面跟着模型名称:

|

||||

|

||||

```python

|

||||

gr.Interface.load("spaces/eugenesiow/remove-bg", inputs="webcam", title="Remove your webcam background!").launch()

|

||||

```

|

||||

|

||||

使用 Gradio 使用加载 Hugging Face 模型或 spaces 的一个很棒的功能是,您可以立即像 Python 代码中的函数一样使用生成的 `Interface` 对象(这适用于每种类型的模型 / 空间:文本,图像,音频,视频,甚至是多模态模型):

|

||||

|

||||

```python

|

||||

io = gr.Interface.load("models/EleutherAI/gpt-neo-2.7B")

|

||||

io("It was the best of times") # outputs model completion

|

||||

```

|

||||

|

||||

## 并行和串行放置接口

|

||||

|

||||

Gradio 还可以使用 `gradio.Parallel` 和 `gradio.Series` 类非常容易地混合接口。`Parallel` 允许您将两个相似的模型(如果它们具有相同的输入类型)并行放置以比较模型预测:

|

||||

|

||||

```python

|

||||

generator1 = gr.Interface.load("huggingface/gpt2")

|

||||

generator2 = gr.Interface.load("huggingface/EleutherAI/gpt-neo-2.7B")

|

||||

generator3 = gr.Interface.load("huggingface/EleutherAI/gpt-j-6B")

|

||||

|

||||

gr.Parallel(generator1, generator2, generator3).launch()

|

||||

```

|

||||

|

||||

`Series` 允许您将模型和 spaces 串行放置,将一个模型的输出传输到下一个模型的输入。

|

||||

|

||||

```python

|

||||

generator = gr.Interface.load("huggingface/gpt2")

|

||||

translator = gr.Interface.load("huggingface/t5-small")

|

||||

|

||||

gr.Series(generator, translator).launch() # this demo generates text, then translates it to German, and outputs the final result.

|

||||

```

|

||||

|

||||

当然,您还可以在适当的情况下同时使用 `Parallel` 和 `Series`!

|

||||

|

||||

在[文档](https://gradio.app/docs#parallel)中了解有关并行和串行 (`Parallel` 和 `Series`) 的更多信息。

|

||||

@ -0,0 +1,44 @@

|

||||

# Gradio 界面的 4 种类型

|

||||

|

||||

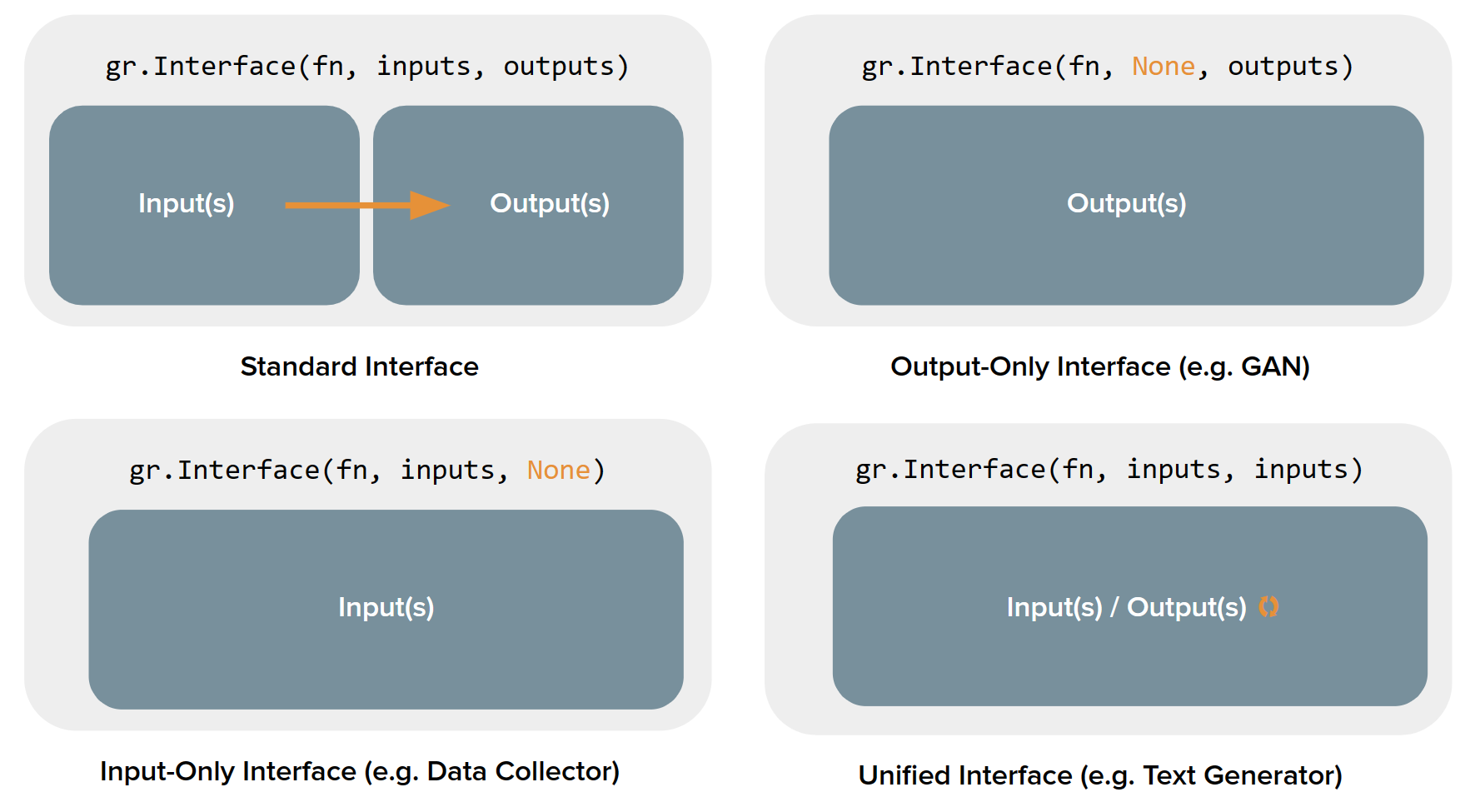

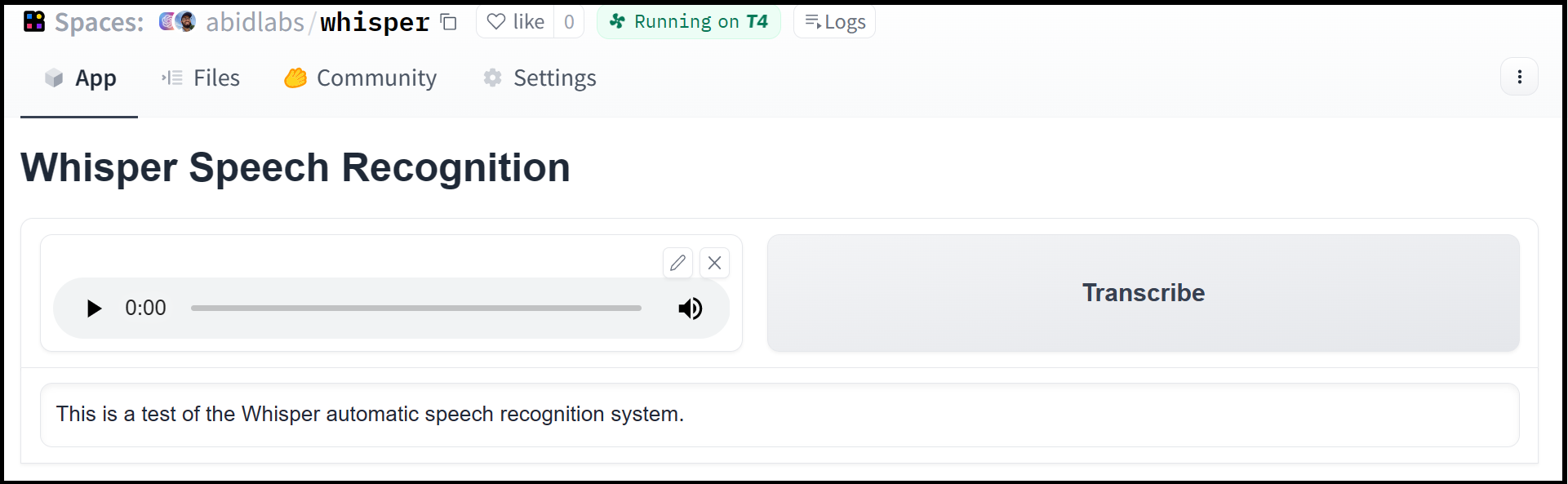

到目前为止,我们一直假设构建 Gradio 演示需要同时具备输入和输出。但对于机器学习演示来说,并不总是如此:例如,*无条件图像生成模型*不需要任何输入,但会生成一张图像作为输出。

|

||||

|

||||

事实证明,`gradio.Interface` 类实际上可以处理 4 种不同类型的演示:

|

||||

|

||||

1. **Standard demos 标准演示**:同时具有独立的输入和输出(例如图像分类器或语音转文本模型)

|

||||

2. **Output-only demos 仅输出演示**:不接受任何输入,但会产生输出(例如无条件图像生成模型)

|

||||

3. **Input-only demos 仅输入演示**:不产生任何输出,但会接受某种形式的输入(例如保存您上传到外部持久数据库的图像的演示)

|

||||

4. **Unified demos 统一演示**:同时具有输入和输出组件,但这些组件是*相同的*。这意味着生成的输出将覆盖输入(例如文本自动完成模型)

|

||||

|

||||

根据演示类型的不同,用户界面(UI)会有略微不同的外观:

|

||||

|

||||

|

||||

|

||||

我们来看一下如何使用 `Interface` 类构建每种类型的演示,以及示例:

|

||||

|

||||

## 标准演示 (Standard demos)

|

||||

|

||||

要创建具有输入和输出组件的演示,只需在 `Interface()` 中设置 `inputs` 和 `outputs` 参数的值。以下是一个简单图像滤镜的示例演示:

|

||||

|

||||

$code_sepia_filter

|

||||

$demo_sepia_filter

|

||||

|

||||

## 仅输出演示 (Output-only demos)

|

||||

|

||||

那么仅包含输出的演示呢?为了构建这样的演示,只需将 `Interface()` 中的 `inputs` 参数值设置为 `None`。以下是模拟图像生成模型的示例演示:

|

||||

|

||||

$code_fake_gan_no_input

|

||||

$demo_fake_gan_no_input

|

||||

|

||||

## 仅输入演示 (Input-only demos)

|

||||

|

||||

同样地,要创建仅包含输入的演示,将 `Interface()` 中的 `outputs` 参数值设置为 `None`。以下是将任何上传的图像保存到磁盘的示例演示:

|

||||

|

||||

$code_save_file_no_output

|

||||

$demo_save_file_no_output

|

||||

|

||||

## 统一演示 (Unified demos)

|

||||

|

||||

这种演示将单个组件同时作为输入和输出。只需将 `Interface()` 中的 `inputs` 和 `outputs` 参数值设置为相同的组件即可创建此演示。以下是文本生成模型的示例演示:

|

||||

|

||||

$code_unified_demo_text_generation

|

||||

$demo_unified_demo_text_generation

|

||||

@ -0,0 +1,157 @@

|

||||

# 区块和事件监听器 (Blocks and Event Listeners)

|

||||

|

||||

我们在[快速入门](https://gradio.app/quickstart/#blocks-more-flexibility-and-control)中简要介绍了区块。让我们深入探讨一下。本指南将涵盖区块的结构、事件监听器及其类型、连续运行事件、更新配置以及使用字典与列表。

|

||||

|

||||

## 区块结构 (Blocks Structure)

|

||||

|

||||

请查看下面的演示。

|

||||

|

||||

$code_hello_blocks

|

||||

$demo_hello_blocks

|

||||

|

||||

- 首先,注意 `with gr.Blocks() as demo:` 子句。区块应用程序代码将被包含在该子句中。

|

||||

- 接下来是组件。这些组件是在 `Interface` 中使用的相同组件。但是,与将组件传递给某个构造函数不同,组件在 `with` 子句内创建时会自动添加到区块中。

|

||||

- 最后,`click()` 事件监听器。事件监听器定义了应用程序内的数据流。在上面的示例中,监听器将两个文本框相互关联。文本框 `name` 作为输入,文本框 `output` 作为 `greet` 方法的输出。当单击按钮 `greet_btn` 时触发此数据流。与界面类似,事件监听器可以具有多个输入或输出。

|

||||

|

||||

## 事件监听器与交互性 (Event Listeners and Interactivity)

|

||||

|

||||

在上面的示例中,您会注意到可以编辑文本框 `name`,但无法编辑文本框 `output`。这是因为作为事件监听器的任何组件都具有交互性。然而,由于文本框 `output` 仅作为输出,它没有交互性。您可以使用 `interactive=` 关键字参数直接配置组件的交互性。

|

||||

|

||||

```python

|

||||

output = gr.Textbox(label="输出", interactive=True)

|

||||

```

|

||||

|

||||

## 事件监听器的类型 (Types of Event Listeners)

|

||||

|

||||

请查看下面的演示:

|

||||

|

||||

$code_blocks_hello

|

||||

$demo_blocks_hello

|

||||

|

||||

`welcome` 函数不是由点击触发的,而是由在文本框 `inp` 中输入文字触发的。这是由于 `change()` 事件监听器。不同的组件支持不同的事件监听器。例如,`Video` 组件支持一个 `play()` 事件监听器,当用户按下播放按钮时触发。有关每个组件的事件监听器,请参见[文档](http://gradio.app/docs#components)。

|

||||

|

||||

## 多个数据流 (Multiple Data Flows)

|

||||

|

||||

区块应用程序不像界面那样限制于单个数据流。请查看下面的演示:

|

||||

|

||||

$code_reversible_flow

|

||||

$demo_reversible_flow

|

||||

|

||||

请注意,`num1` 可以充当 `num2` 的输入,反之亦然!随着应用程序变得更加复杂,您将能够连接各种组件的多个数据流。

|

||||

|

||||

下面是一个 " 多步骤 " 示例,其中一个模型的输出(语音到文本模型)被传递给下一个模型(情感分类器)。

|

||||

|

||||

$code_blocks_speech_text_sentiment

|

||||

$demo_blocks_speech_text_sentiment

|

||||

|

||||

## 函数输入列表与字典 (Function Input List vs Dict)

|

||||

|

||||

到目前为止,您看到的事件监听器都只有一个输入组件。如果您希望有多个输入组件将数据传递给函数,有两种选项可供函数接受输入组件值:

|

||||

|

||||

1. 作为参数列表,或

|

||||

2. 作为以组件为键的单个值字典

|

||||

|

||||

让我们分别看一个例子:

|

||||

$code_calculator_list_and_dict

|

||||

|

||||

`add()` 和 `sub()` 都将 `a` 和 `b` 作为输入。然而,这些监听器之间的语法不同。

|

||||

|

||||

1. 对于 `add_btn` 监听器,我们将输入作为列表传递。函数 `add()` 将每个输入作为参数。`a` 的值映射到参数 `num1`,`b` 的值映射到参数 `num2`。

|

||||

2. 对于 `sub_btn` 监听器,我们将输入作为集合传递(注意花括号!)。函数 `sub()` 接受一个名为 `data` 的单个字典参数,其中键是输入组件,值是这些组件的值。

|

||||

|

||||

使用哪种语法是个人偏好!对于具有许多输入组件的函数,选项 2 可能更容易管理。

|

||||

|

||||

$demo_calculator_list_and_dict

|

||||

|

||||

## 函数返回列表与字典 (Function Return List vs Dict)

|

||||

|

||||

类似地,您可以返回多个输出组件的值,可以是:

|

||||

|

||||

1. 值列表,或

|

||||

2. 以组件为键的字典

|

||||

|

||||

首先让我们看一个(1)的示例,其中我们通过返回两个值来设置两个输出组件的值:

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

food_box = gr.Number(value=10, label="Food Count")

|

||||

status_box = gr.Textbox()

|

||||

def eat(food):

|

||||

if food > 0:

|

||||

return food - 1, "full"

|

||||

else:

|

||||

return 0, "hungry"

|

||||

gr.Button("EAT").click(

|

||||

fn=eat,

|

||||

inputs=food_box,

|

||||

outputs=[food_box, status_box]

|

||||

)

|

||||

```

|

||||

|

||||

上面的每个返回语句分别返回与 `food_box` 和 `status_box` 相对应的两个值。

|

||||

|

||||

除了返回与每个输出组件顺序相对应的值列表外,您还可以返回一个字典,其中键对应于输出组件,值作为新值。这还允许您跳过更新某些输出组件。

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

food_box = gr.Number(value=10, label="Food Count")

|

||||

status_box = gr.Textbox()

|

||||

def eat(food):

|

||||

if food > 0:

|

||||

return {food_box: food - 1, status_box: "full"}

|

||||

else:

|

||||

return {status_box: "hungry"}

|

||||

gr.Button("EAT").click(

|

||||

fn=eat,

|

||||

inputs=food_box,

|

||||

outputs=[food_box, status_box]

|

||||

)

|

||||

```

|

||||

|

||||

注意,在没有食物的情况下,我们只更新 `status_box` 元素。我们跳过更新 `food_box` 组件。

|

||||

|

||||

字典返回在事件监听器影响多个组件的返回值或有条件地影响输出时非常有用。

|

||||

|

||||

请记住,对于字典返回,我们仍然需要在事件监听器中指定可能的输出组件。

|

||||

|

||||

## 更新组件配置 (Updating Component Configurations)

|

||||

|

||||

事件监听器函数的返回值通常是相应输出组件的更新值。有时我们还希望更新组件的配置,例如可见性。在这种情况下,我们返回一个 `gr.update()` 对象,而不仅仅是更新组件的值。

|

||||

|

||||

$code_blocks_essay_update

|

||||

$demo_blocks_essay_update

|

||||

|

||||

请注意,我们可以通过 `gr.update()` 方法自我配置文本框。`value=` 参数仍然可以用于更新值以及组件配置。

|

||||

|

||||

## 连续运行事件 (Running Events Consecutively)

|

||||

|

||||

你也可以使用事件监听器的 `then` 方法按顺序运行事件。在前一个事件运行完成后,这将运行下一个事件。这对于多步更新组件的事件非常有用。

|

||||

|

||||

例如,在下面的聊天机器人示例中,我们首先立即使用用户消息更新聊天机器人,然后在模拟延迟后使用计算机回复更新聊天机器人。

|

||||

|

||||

$code_chatbot_simple

|

||||

$demo_chatbot_simple

|

||||

|

||||

事件监听器的 `.then()` 方法会执行后续事件,无论前一个事件是否引发任何错误。如果只想在前一个事件成功执行后才运行后续事件,请使用 `.success()` 方法,该方法与 `.then()` 接受相同的参数。

|

||||

|

||||

## 连续运行事件 (Running Events Continuously)

|

||||

|

||||

您可以使用事件监听器的 `every` 参数按固定计划运行事件。这将在客户端连接打开的情况下,每隔一定秒数运行一次事件。如果连接关闭,事件将在下一次迭代后停止运行。

|

||||

请注意,这不考虑事件本身的运行时间。因此,使用 `every=5` 运行时间为 1 秒的函数实际上每 6 秒运行一次。

|

||||

|

||||

以下是每秒更新的正弦曲线示例!

|

||||

|

||||

$code_sine_curve

|

||||

$demo_sine_curve

|

||||

|

||||

## 收集事件数据 (Gathering Event Data)

|

||||

|

||||

您可以通过将相关的事件数据类作为类型提示添加到事件监听器函数的参数中,收集有关事件的特定数据。

|

||||

|

||||

例如,使用 `gradio.SelectData` 参数可以为 `.select()` 的事件数据添加类型提示。当用户选择触发组件的一部分时,将触发此事件,并且事件数据包含有关用户的具体选择的信息。如果用户在 `Textbox` 中选择了特定单词,在 `Gallery` 中选择了特定图像或在 `DataFrame` 中选择了特定单元格,则事件数据参数将包含有关具体选择的信息。

|

||||

|

||||

在下面的双人井字游戏演示中,用户可以选择 `DataFrame` 中的一个单元格进行移动。事件数据参数包含有关所选单元格的信息。我们可以首先检查单元格是否为空,然后用用户的移动更新单元格。

|

||||

|

||||

$code_tictactoe

|

||||

|

||||

$demo_tictactoe

|

||||

95

guides/cn/03_building-with-blocks/02_controlling-layout.md

Normal file

@ -0,0 +1,95 @@

|

||||

# 控制布局 (Controlling Layout)

|

||||

|

||||

默认情况下,块中的组件是垂直排列的。让我们看看如何重新排列组件。在幕后,这种布局结构使用了[Web 开发的 flexbox 模型](https://developer.mozilla.org/en-US/docs/Web/CSS/CSS_Flexible_Box_Layout/Basic_Concepts_of_Flexbox)。

|

||||

|

||||

## Row 行

|

||||

|

||||

`with gr.Row` 下的元素将水平显示。例如,要并排显示两个按钮:

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

with gr.Row():

|

||||

btn1 = gr.Button("按钮1")

|

||||

btn2 = gr.Button("按钮2")

|

||||

```

|

||||

|

||||

要使行中的每个元素具有相同的高度,请使用 `style` 方法的 `equal_height` 参数。

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

with gr.Row().style(equal_height=True):

|

||||

textbox = gr.Textbox()

|

||||

btn2 = gr.Button("按钮2")

|

||||

```

|

||||

|

||||

可以通过每个组件中存在的 `scale` 和 `min_width` 参数来控制行中元素的宽度。

|

||||

|

||||

- `scale` 是一个整数,定义了元素在行中的占用空间。如果将 scale 设置为 `0`,则元素不会扩展占用空间。如果将 scale 设置为 `1` 或更大,则元素将扩展。行中的多个元素将按比例扩展。在下面的示例中,`btn1` 将比 `btn2` 扩展两倍,而 `btn0` 将根本不会扩展:

|

||||

|

||||

```python

|

||||

with gr.Blocks() as demo:

|

||||

with gr.Row():

|

||||

btn0 = gr.Button("按钮0", scale=0)

|

||||

btn1 = gr.Button("按钮1", scale=1)

|

||||

btn2 = gr.Button("按钮2", scale=2)

|

||||

```

|

||||

|

||||

- `min_width` 将设置元素的最小宽度。如果没有足够的空间满足所有的 `min_width` 值,行将换行。

|

||||

|

||||

在[文档](https://gradio.app/docs/#row)中了解有关行的更多信息。

|

||||

|

||||

## 列和嵌套 (Columns and Nesting)

|

||||

|

||||

列中的组件将垂直放置在一起。由于默认布局对于块应用程序来说是垂直布局,因此为了有用,列通常嵌套在行中。例如:

|

||||

|

||||

$code_rows_and_columns

|

||||

$demo_rows_and_columns

|

||||

|

||||

查看第一列如何垂直排列两个文本框。第二列垂直排列图像和按钮。注意两列的相对宽度由 `scale` 参数设置。具有两倍 `scale` 值的列占据两倍的宽度。

|

||||

|

||||

在[文档](https://gradio.app/docs/#column)中了解有关列的更多信息。

|

||||

|

||||

## 选项卡和手风琴 (Tabs and Accordions)

|

||||

|

||||

您还可以使用 `with gr.Tab('tab_name'):` 语句创建选项卡。在 `with gr.Tab('tab_name'):` 上下文中创建的任何组件都将显示在该选项卡中。连续的 Tab 子句被分组在一起,以便一次只能选择一个选项卡,并且只显示该选项卡上下文中的组件。

|

||||

|

||||

例如:

|

||||

|

||||

$code_blocks_flipper

|

||||

$demo_blocks_flipper

|

||||

|

||||

还请注意本示例中的 `gr.Accordion('label')`。手风琴是一种可以切换打开或关闭的布局。与 `Tabs` 一样,它是可以选择性隐藏或显示内容的布局元素。在 `with gr.Accordion('label'):` 内定义的任何组件在单击手风琴的切换图标时都会被隐藏或显示。

|

||||

|

||||

在文档中了解有关[Tabs](https://gradio.app/docs/#tab)和[Accordions](https://gradio.app/docs/#accordion)的更多信息。

|

||||

|

||||

## 可见性 (Visibility)

|

||||

|

||||

组件和布局元素都有一个 `visible` 参数,可以在初始时设置,并使用 `gr.update()` 进行更新。在 Column 上设置 `gr.update(visible=...)` 可用于显示或隐藏一组组件。

|

||||

|

||||

$code_blocks_form

|

||||

$demo_blocks_form

|

||||

|

||||

## 可变数量的输出 (Variable Number of Outputs)

|

||||

|

||||

通过以动态方式调整组件的可见性,可以创建支持 *可变数量输出* 的 Gradio 演示。这是一个非常简单的例子,其中输出文本框的数量由输入滑块控制:

|

||||

|

||||

例如:

|

||||

|

||||

$code_variable_outputs

|

||||

$demo_variable_outputs

|

||||

|

||||

## 分开定义和渲染组件 (Defining and Rendering Components Separately)

|

||||

|

||||

在某些情况下,您可能希望在实际渲染 UI 之前定义组件。例如,您可能希望在相应的 `gr.Textbox` 输入上方显示示例部分,使用 `gr.Examples`。由于 `gr.Examples` 需要一个参数作为输入组件对象,您需要先定义输入组件,然后在定义 `gr.Examples` 对象之后再渲染它。

|

||||

|

||||

解决方法是在 `gr.Blocks()` 范围之外定义 `gr.Textbox`,并在 UI 中想要放置它的位置使用组件的 `.render()` 方法。

|

||||

|

||||

这是一个完整的代码示例:

|

||||

|

||||

```python

|

||||

input_textbox = gr.Textbox()

|

||||

|

||||

with gr.Blocks() as demo:

|

||||

gr.Examples(["hello", "bonjour", "merhaba"], input_textbox)

|

||||

input_textbox.render()

|

||||

```

|

||||

30

guides/cn/03_building-with-blocks/03_state-in-blocks.md

Normal file

@ -0,0 +1,30 @@

|

||||

# 分块状态 (State in Blocks)

|

||||

|

||||

我们已经介绍了[接口状态](https://gradio.app/interface-state),这篇指南将介绍分块状态,它的工作原理大致相同。

|

||||

|

||||

## 全局状态 (Global State)

|

||||

|

||||

分块中的全局状态与接口中的全局状态相同。在函数调用外创建的任何变量都是在所有用户之间共享的引用。

|

||||

|

||||

## 会话状态 (Session State)

|

||||

|

||||

Gradio 在分块应用程序中同样支持会话**状态**,即在页面会话中跨多次提交保持的数据。需要再次强调,会话数据*不会*在模型的不同用户之间共享。要在会话状态中存储数据,需要完成以下三个步骤:

|

||||

|

||||

1. 创建一个 `gr.State()` 对象。如果此可状态对象有一个默认值,请将其传递给构造函数。

|

||||

2. 在事件监听器中,将 `State` 对象作为输入和输出。

|

||||

3. 在事件监听器函数中,将变量添加到输入参数和返回值中。

|

||||

|

||||

让我们来看一个猜词游戏的例子。

|

||||

|

||||

$code_hangman

|

||||

$demo_hangman

|

||||

|

||||

让我们看看在这个游戏中如何完成上述的 3 个步骤:

|

||||

|

||||

1. 我们将已使用的字母存储在 `used_letters_var` 中。在 `State` 的构造函数中,将其初始值设置为空列表`[]`。

|

||||

2. 在 `btn.click()` 中,我们在输入和输出中都引用了 `used_letters_var`。

|

||||

3. 在 `guess_letter` 中,我们将此 `State` 的值传递给 `used_letters`,然后在返回语句中返回更新后的该 `State` 的值。

|

||||

|

||||

对于更复杂的应用程序,您可能会在一个单独的分块应用程序中使用许多存储会话状态的 `State` 变量。

|

||||

|

||||

在[文档](https://gradio.app/docs#state)中了解更多关于 `State` 的信息。

|

||||

57

guides/cn/03_building-with-blocks/04_custom-CSS-and-JS.md

Normal file

@ -0,0 +1,57 @@

|

||||

# 自定义的 JS 和 CSS

|

||||

|

||||

本指南介绍了如何更灵活地为 Blocks 添加样式,并添加 JavaScript 代码到事件监听器中。

|

||||

|

||||

**警告**:在自定义的 JS 和 CSS 中使用查询选择器不能保证能在所有 Gradio 版本中正常工作,因为 Gradio 的 HTML DOM 可能会发生变化。我们建议谨慎使用查询选择器。

|

||||

|

||||

## 自定义的 CSS

|

||||

|

||||

Gradio 主题是自定义应用程序外观和感觉的最简单方式。您可以从各种主题中进行选择,或者创建自己的主题。要实现这一点,请将 `theme=` kwarg 传递给 `Blocks` 构造函数。例如:

|

||||

|

||||

```python

|

||||

with gr.Blocks(theme=gr.themes.Glass()):

|

||||

...

|

||||

```

|

||||

|

||||

Gradio 自带一套预构建的主题,您可以从 `gr.themes.*` 中加载这些主题。您可以扩展这些主题,或者从头开始创建自己的主题 - 有关更多详细信息,请参阅[主题指南](/theming-guide)。

|

||||

|

||||

要增加附加的样式能力,您可以使用 `css=` kwarg 将任何 CSS 传递给您的应用程序。

|

||||

|

||||

Gradio 应用程序的基类是 `gradio-container`,因此下面是一个示例,用于更改 Gradio 应用程序的背景颜色:

|

||||

```python

|

||||

with gr.Blocks(css=".gradio-container {background-color: red}") as demo:

|

||||

...

|

||||

```

|

||||

|

||||

如果您想在您的 CSS 中引用外部文件,请使用 `"file="` 作为文件路径的前缀(可以是相对路径或绝对路径),例如:

|

||||

|

||||

```python

|

||||

with gr.Blocks(css=".gradio-container {background: url('file=clouds.jpg')}") as demo:

|

||||

...

|

||||

```

|

||||

|

||||

您还可以将 CSS 文件的文件路径传递给 `css` 参数。

|

||||

|

||||

## `elem_id` 和 `elem_classes` 参数

|

||||

|

||||

您可以使用 `elem_id` 来为任何组件添加 HTML 元素 `id`,并使用 `elem_classes` 添加一个类或类列表。这将使您能够更轻松地使用 CSS 选择元素。这种方法更有可能在 Gradio 版本之间保持稳定,因为内置的类名或 id 可能会发生变化(但正如上面的警告中所提到的,如果您使用自定义 CSS,我们不能保证在 Gradio 版本之间完全兼容,因为 DOM 元素本身可能会发生变化)。

|

||||

|

||||

```python

|

||||

css = """

|

||||

#warning {background-color: #FFCCCB}

|

||||

.feedback textarea {font-size: 24px !important}

|

||||

"""

|

||||

|

||||

with gr.Blocks(css=css) as demo:

|

||||

box1 = gr.Textbox(value="Good Job", elem_classes="feedback")

|

||||

box2 = gr.Textbox(value="Failure", elem_id="warning", elem_classes="feedback")

|

||||

```

|

||||

|

||||

CSS `#warning` 规则集仅针对第二个文本框,而 `.feedback` 规则集将同时作用于两个文本框。请注意,在针对类时,您可能需要使用 `!important` 选择器来覆盖默认的 Gradio 样式。

|

||||

|

||||

## 自定义的 JS

|

||||

|

||||

事件监听器具有 `_js` 参数,可以接受 JavaScript 函数作为字符串,并像 Python 事件监听器函数一样处理它。您可以传递 JavaScript 函数和 Python 函数(在这种情况下,先运行 JavaScript 函数),或者仅传递 JavaScript(并将 Python 的 `fn` 设置为 `None`)。请查看下面的代码:

|

||||

|

||||

$code_blocks_js_methods

|

||||

$demo_blocks_js_methods

|

||||

@ -0,0 +1,89 @@

|

||||

# 使用 Gradio 块像函数一样

|

||||

Tags: TRANSLATION, HUB, SPACES

|

||||

|

||||

**先决条件**: 本指南是在块介绍的基础上构建的。请确保[先阅读该指南](https://gradio.app/quickstart/#blocks-more-flexibility-and-control)。

|

||||

|

||||

## 介绍

|

||||

|

||||

你知道吗,除了作为一个全栈机器学习演示,Gradio 块应用其实也是一个普通的 Python 函数!?

|

||||

|

||||

这意味着如果你有一个名为 `demo` 的 Gradio 块(或界面)应用,你可以像使用任何 Python 函数一样使用 `demo`。

|

||||

|

||||

所以,像 `output = demo("Hello", "friend")` 这样的操作会在输入为 "Hello" 和 "friend" 的情况下运行 `demo` 中定义的第一个事件,并将其存储在变量 `output` 中。

|

||||

|

||||

如果以上内容让你打瞌睡 🥱,请忍耐一下!通过将应用程序像函数一样使用,你可以轻松地组合 Gradio 应用。

|

||||

接下来的部分将展示如何实现。

|

||||

|

||||

## 将块视为函数

|

||||

|

||||

假设我们有一个将英文文本翻译为德文文本的演示块。

|

||||

|

||||

$code_english_translator

|

||||

|

||||

我已经将它托管在 Hugging Face Spaces 上的 [gradio/english_translator](https://huggingface.co/spaces/gradio/english_translator)。

|

||||

|

||||

你也可以在下面看到演示:

|

||||

|

||||

$demo_english_translator

|

||||

|

||||

现在,假设你有一个生成英文文本的应用程序,但你还想额外生成德文文本。

|

||||

|

||||

你可以选择:

|

||||

|

||||

1. 将我的英德翻译的源代码复制粘贴到你的应用程序中。

|

||||

|

||||

2. 在你的应用程序中加载我的英德翻译,并将其当作普通的 Python 函数处理。

|

||||

|

||||

选项 1 从技术上讲总是有效的,但它经常引入不必要的复杂性。

|

||||

|

||||

选项 2 允许你借用所需的功能,而不会过于紧密地耦合我们的应用程序。

|

||||

|

||||

你只需要在源文件中调用 `Blocks.load` 类方法即可。

|

||||

之后,你就可以像使用普通的 Python 函数一样使用我的翻译应用程序了!

|

||||

|

||||

下面的代码片段和演示展示了如何使用 `Blocks.load`。

|

||||

|

||||

请注意,变量 `english_translator` 是我的英德翻译应用程序,但它在 `generate_text` 中像普通函数一样使用。

|

||||

|

||||

$code_generate_english_german

|

||||

|

||||

$demo_generate_english_german

|

||||

|

||||

## 如何控制使用应用程序中的哪个函数

|

||||

|

||||

如果你正在加载的应用程序定义了多个函数,你可以使用 `fn_index` 和 `api_name` 参数指定要使用的函数。

|

||||

|

||||

在英德演示的代码中,你会看到以下代码行:

|

||||

|

||||

translate_btn.click(translate, inputs=english, outputs=german, api_name="translate-to-german")

|

||||

|

||||

这个 `api_name` 在我们的应用程序中给这个函数一个唯一的名称。你可以使用这个名称告诉 Gradio 你想使用

|

||||

上游空间中的哪个函数:

|

||||

|

||||

english_generator(text, api_name="translate-to-german")[0]["generated_text"]

|

||||

|

||||

你也可以使用 `fn_index` 参数。

|

||||

假设我的应用程序还定义了一个英语到西班牙语的翻译函数。

|

||||

为了在我们的文本生成应用程序中使用它,我们将使用以下代码:

|

||||

|

||||

english_generator(text, fn_index=1)[0]["generated_text"]

|

||||

|

||||

Gradio 空间中的函数是从零开始索引的,所以西班牙语翻译器将是我的空间中的第二个函数,

|

||||

因此你会使用索引 1。

|

||||

|

||||

## 结语

|

||||

|

||||

我们展示了将块应用视为普通 Python 函数的方法,这有助于在不同的应用程序之间组合功能。

|

||||

任何块应用程序都可以被视为一个函数,但一个强大的模式是在将其视为函数之前,

|

||||

在[自己的应用程序中加载](https://huggingface.co/spaces)托管在[Hugging Face Spaces](https://huggingface.co/spaces)上的应用程序。

|

||||

您也可以加载托管在[Hugging Face Model Hub](https://huggingface.co/models)上的模型——有关示例,请参阅[使用 Hugging Face 集成](/using_hugging_face_integrations)指南。

|

||||

|

||||

### 开始构建!⚒️

|

||||

|

||||

## Parting Remarks

|

||||

|

||||

我们展示了如何将 Blocks 应用程序视为常规 Python 函数,以便在不同的应用程序之间组合功能。

|

||||

任何 Blocks 应用程序都可以被视为函数,但是一种有效的模式是在将其视为自己应用程序的函数之前,先`加载`托管在[Hugging Face Spaces](https://huggingface.co/spaces)上的应用程序。

|

||||

您还可以加载托管在[Hugging Face Model Hub](https://huggingface.co/models)上的模型-请参见[使用 Hugging Face 集成指南](/using_hugging_face_integrations)中的示例。

|

||||

|

||||

### Happy building! ⚒️

|

||||

@ -0,0 +1,135 @@

|

||||

# 使用 Hugging Face 集成

|

||||

|

||||

相关空间:https://huggingface.co/spaces/gradio/helsinki_translation_en_es

|

||||

标签:HUB,SPACES,EMBED

|

||||

|

||||

由 <a href="https://huggingface.co/osanseviero">Omar Sanseviero</a> 贡献🦙

|

||||

|

||||

## 介绍

|

||||

|

||||

Hugging Face Hub 是一个集成平台,拥有超过 190,000 个[模型](https://huggingface.co/models),32,000 个[数据集](https://huggingface.co/datasets)和 40,000 个[演示](https://huggingface.co/spaces),也被称为 Spaces。虽然 Hugging Face 以其🤗 transformers 和 diffusers 库而闻名,但 Hub 还支持许多机器学习库,如 PyTorch,TensorFlow,spaCy 等,涵盖了从计算机视觉到强化学习等各个领域。

|

||||

|

||||

Gradio 拥有多个功能,使其非常容易利用 Hub 上的现有模型和 Spaces。本指南将介绍这些功能。

|

||||

|

||||

## 使用 `pipeline` 进行常规推理

|

||||

|

||||

首先,让我们构建一个简单的界面,将英文翻译成西班牙文。在赫尔辛基大学共享的一千多个模型中,有一个[现有模型](https://huggingface.co/Helsinki-NLP/opus-mt-en-es),名为 `opus-mt-en-es`,可以正好做到这一点!

|

||||

|

||||

🤗 transformers 库有一个非常易于使用的抽象层,[`pipeline()`](https://huggingface.co/docs/transformers/v4.16.2/en/main_classes/pipelines#transformers.pipeline)处理大部分复杂代码,为常见任务提供简单的 API。通过指定任务和(可选)模型,您可以使用几行代码使用现有模型:

|

||||

|

||||

```python

|

||||

import gradio as gr

|

||||

|

||||

from transformers import pipeline

|

||||

|

||||

pipe = pipeline("translation", model="Helsinki-NLP/opus-mt-en-es")

|

||||

|

||||

def predict(text):

|

||||

return pipe(text)[0]["translation_text"]

|

||||

|

||||

demo = gr.Interface(

|

||||

fn=predict,

|

||||

inputs='text',

|

||||

outputs='text',

|

||||

)

|

||||

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

但是,`gradio` 实际上使将 `pipeline` 转换为演示更加容易,只需使用 `gradio.Interface.from_pipeline` 方法,无需指定输入和输出组件:

|

||||

|

||||

```python

|

||||

from transformers import pipeline

|

||||

import gradio as gr

|

||||

|

||||

pipe = pipeline("translation", model="Helsinki-NLP/opus-mt-en-es")

|

||||

|

||||

demo = gr.Interface.from_pipeline(pipe)

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

上述代码生成了以下界面,您可以在浏览器中直接尝试:

|

||||

|

||||

<gradio-app space="Helsinki-NLP/opus-mt-en-es"></gradio-app>

|

||||

|

||||

## Using Hugging Face Inference API

|

||||

|

||||

Hugging Face 提供了一个名为[Inference API](https://huggingface.co/inference-api)的免费服务,允许您向 Hub 中的模型发送 HTTP 请求。对于基于 transformers 或 diffusers 的模型,API 的速度可以比自己运行推理快 2 到 10 倍。该 API 是免费的(受速率限制),您可以在想要在生产中使用时切换到专用的[推理端点](https://huggingface.co/pricing)。

|

||||

|

||||

让我们尝试使用推理 API 而不是自己加载模型的方式进行相同的演示。鉴于 Inference API 支持的 Hugging Face 模型,Gradio 可以自动推断出预期的输入和输出,并进行底层服务器调用,因此您不必担心定义预测函数。以下是代码示例!

|

||||

|

||||

```python

|

||||

import gradio as gr

|

||||

|

||||

demo = gr.load("Helsinki-NLP/opus-mt-en-es", src="models")

|

||||

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

请注意,我们只需指定模型名称并说明 `src` 应为 `models`(Hugging Face 的 Model Hub)。由于您不会在计算机上加载模型,因此无需安装任何依赖项(除了 `gradio`)。

|

||||

|

||||

您可能会注意到,第一次推理大约需要 20 秒。这是因为推理 API 正在服务器中加载模型。之后您会获得一些好处:

|

||||

|

||||

* 推理速度更快。

|

||||

* 服务器缓存您的请求。

|

||||

* 您获得内置的自动缩放功能。

|

||||

|

||||

## 托管您的 Gradio 演示

|

||||

|

||||

[Hugging Face Spaces](https://hf.co/spaces)允许任何人免费托管其 Gradio 演示,上传 Gradio 演示只需几分钟。您可以前往[hf.co/new-space](https://huggingface.co/new-space),选择 Gradio SDK,创建一个 `app.py` 文件,完成!您将拥有一个可以与任何人共享的演示。要了解更多信息,请阅读[此指南以使用网站在 Hugging Face Spaces 上托管](https://huggingface.co/blog/gradio-spaces)。

|

||||

|

||||

或者,您可以通过使用[huggingface_hub client library](https://huggingface.co/docs/huggingface_hub/index)库来以编程方式创建一个 Space。这是一个示例:

|

||||

|

||||

```python

|

||||

from huggingface_hub import (

|

||||

create_repo,

|

||||

get_full_repo_name,

|

||||

upload_file,

|

||||

)

|

||||

create_repo(name=target_space_name, token=hf_token, repo_type="space", space_sdk="gradio")

|

||||

repo_name = get_full_repo_name(model_id=target_space_name, token=hf_token)

|

||||

file_url = upload_file(

|

||||

path_or_fileobj="file.txt",

|

||||

path_in_repo="app.py",

|

||||

repo_id=repo_name,

|

||||

repo_type="space",

|

||||

token=hf_token,

|

||||

)

|

||||

```

|

||||

在这里,`create_repo` 使用特定帐户的 Write Token 在特定帐户下创建一个带有目标名称的 gradio repo。`repo_name` 获取相关存储库的完整存储库名称。最后,`upload_file` 将文件上传到存储库中,并将其命名为 `app.py`。

|

||||

|

||||

## 在其他网站上嵌入您的 Space 演示

|

||||

|

||||

在本指南中,您已经看到了许多嵌入的 Gradio 演示。您也可以在自己的网站上这样做!第一步是创建一个包含您想展示的演示的 Hugging Face Space。然后,[按照此处的步骤将 Space 嵌入到您的网站上](/sharing-your-app/#embedding-hosted-spaces)。

|

||||

|

||||

## 从 Spaces 加载演示

|

||||

|

||||

您还可以在 Hugging Face Spaces 上使用和混合现有的 Gradio 演示。例如,您可以将两个现有的 Gradio 演示放在单独的选项卡中并创建一个新的演示。您可以在本地运行此新演示,或将其上传到 Spaces,为混合和创建新的演示提供无限可能性!

|

||||

|

||||

以下是一个完全实现此目标的示例:

|

||||

|

||||

```python

|

||||

import gradio as gr

|

||||

|

||||

with gr.Blocks() as demo:

|

||||

with gr.Tab("Translate to Spanish"):

|

||||

gr.load("gradio/helsinki_translation_en_es", src="spaces")

|

||||

with gr.Tab("Translate to French"):

|

||||

gr.load("abidlabs/en2fr", src="spaces")

|

||||

|

||||

demo.launch()

|

||||

```

|

||||

|

||||

请注意,我们使用了 `gr.load()`,这与使用推理 API 加载模型所使用的方法相同。但是,在这里,我们指定 `src` 为 `spaces`(Hugging Face Spaces)。

|

||||

|

||||

## 小结

|

||||

|

||||

就是这样!让我们回顾一下 Gradio 和 Hugging Face 共同工作的各种方式:

|

||||

|

||||

1. 您可以使用 `from_pipeline()` 将 `transformers` pipeline 转换为 Gradio 演示

|

||||

2. 您可以使用 `gr.load()` 轻松地围绕推理 API 构建演示,而无需加载模型

|

||||

3. 您可以在 Hugging Face Spaces 上托管您的 Gradio 演示,可以使用 GUI 或完全使用 Python。

|

||||

4. 您可以将托管在 Hugging Face Spaces 上的 Gradio 演示嵌入到自己的网站上。

|

||||

5. 您可以使用 `gr.load()` 从 Hugging Face Spaces 加载演示,以重新混合和创建新的 Gradio 演示。

|

||||

|

||||

🤗

|

||||

269

guides/cn/04_integrating-other-frameworks/Gradio-and-Comet.md

Normal file

@ -0,0 +1,269 @@

|

||||

# 使用 Gradio 和 Comet

|

||||

|

||||

Tags: COMET, SPACES

|

||||

由 Comet 团队贡献

|

||||

|

||||

## 介绍

|

||||

|

||||

在这个指南中,我们将展示您可以如何使用 Gradio 和 Comet。我们将介绍使用 Comet 和 Gradio 的基本知识,并向您展示如何利用 Gradio 的高级功能,如 [使用 iFrames 进行嵌入](https://www.gradio.app/sharing-your-app/#embedding-with-iframes) 和 [状态](https://www.gradio.app/docs/#state) 来构建一些令人惊叹的模型评估工作流程。

|

||||

|

||||

下面是本指南涵盖的主题列表。

|

||||

|

||||

1. 将 Gradio UI 记录到您的 Comet 实验中

|

||||

2. 直接将 Gradio 应用程序嵌入到您的 Comet 项目中

|

||||

3. 直接将 Hugging Face Spaces 嵌入到您的 Comet 项目中

|

||||

4. 将 Gradio 应用程序的模型推理记录到 Comet 中

|

||||

|

||||

## 什么是 Comet?

|

||||

|

||||

[Comet](https://www.comet.com?utm_source=gradio&utm_medium=referral&utm_campaign=gradio-integration&utm_content=gradio-docs) 是一个 MLOps 平台,旨在帮助数据科学家和团队更快地构建更好的模型!Comet 提供工具来跟踪、解释、管理和监控您的模型,集中在一个地方!它可以与 Jupyter 笔记本和脚本配合使用,最重要的是,它是 100% 免费的!

|

||||

|

||||

## 设置

|

||||

|

||||

首先,安装运行这些示例所需的依赖项

|

||||

|

||||

```shell

|

||||

pip install comet_ml torch torchvision transformers gradio shap requests Pillow

|

||||

```

|

||||

|

||||

接下来,您需要[注册一个 Comet 账户](https://www.comet.com/signup?utm_source=gradio&utm_medium=referral&utm_campaign=gradio-integration&utm_content=gradio-docs)。一旦您设置了您的账户,[获取您的 API 密钥](https://www.comet.com/docs/v2/guides/getting-started/quickstart/#get-an-api-key?utm_source=gradio&utm_medium=referral&utm_campaign=gradio-integration&utm_content=gradio-docs) 并配置您的 Comet 凭据

|

||||

|

||||

如果您将这些示例作为脚本运行,您可以将您的凭据导出为环境变量

|

||||

|

||||

```shell

|

||||

export COMET_API_KEY="<您的 API 密钥>"

|

||||

export COMET_WORKSPACE="<您的工作空间名称>"

|

||||

export COMET_PROJECT_NAME="<您的项目名称>"

|

||||

```

|

||||

|

||||

或者将它们设置在您的工作目录中的 `.comet.config` 文件中。您的文件应按以下方式格式化。